这份指南将从课程目标、核心模块、学习路径、选择建议等多个维度展开,旨在帮助不同背景的学习者找到最适合自己的学习方向。

(图片来源网络,侵删)

课程目标与定位

大数据培训课程的目标是培养能够胜任企业大数据岗位的复合型人才,根据不同的岗位方向,课程目标有所侧重:

-

大数据开发工程师:

- 目标:掌握大数据技术栈,能够设计、搭建、开发和维护稳定、高效的大数据处理平台和数据管道。

- 核心能力:平台搭建、数据采集、数据存储、数据计算、任务调度。

-

大数据分析师/数据挖掘工程师:

- 目标:运用统计学、机器学习等方法,对海量数据进行清洗、分析、建模,从中发现业务规律,为决策提供支持。

- 核心能力:SQL精通、Python编程、统计分析、数据可视化、机器学习算法。

-

数据平台运维工程师:

(图片来源网络,侵删)

(图片来源网络,侵删)- 目标:保障大数据集群的稳定、安全、高效运行,进行性能优化、故障排查和容量规划。

- 核心能力:Linux/Shell、网络知识、分布式系统原理、集群监控与调优。

-

数据产品经理:

- 目标:理解数据价值,设计数据产品(如BI报表系统、推荐系统、用户画像系统等),连接技术与业务。

- 核心能力:业务理解、产品设计、数据敏感度、沟通协调。

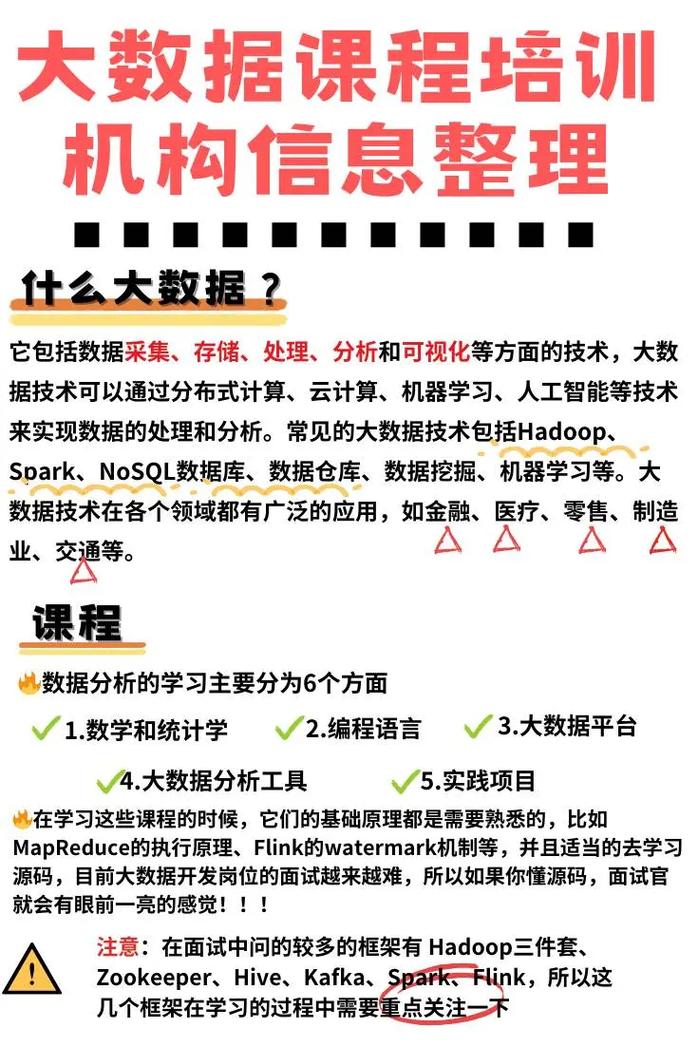

核心课程模块(理论与实践结合)

一个完整的大数据培训课程通常包含以下模块,不同方向的课程会各有侧重。

基础理论与编程语言

这是所有大数据方向的基石,必不可少。

- Linux操作系统:

- 常用命令、文件管理、用户权限、Shell脚本编程。

- 为什么重要:大数据集群几乎都部署在Linux系统上,所有操作和自动化运维都依赖Shell。

- Python编程语言:

- 语法基础、数据结构、函数、面向对象、常用库(

NumPy,Pandas,Matplotlib,Scikit-learn)。 - 为什么重要:数据分析、数据挖掘、机器学习领域的“瑞士军刀”,也是Spark等框架的重要支持语言。

- 语法基础、数据结构、函数、面向对象、常用库(

- SQL语言:

- DDL、DML、聚合函数、分组、连接、子查询、窗口函数。

- 为什么重要:数据获取的“通用语言”,无论是数据仓库还是数据湖,SQL都是最核心的查询工具。

- 统计学与数学基础:

- 描述性统计、概率论基础、假设检验、回归分析、常见分布。

- 为什么重要:理解数据分布、评估模型效果、进行科学分析的底层逻辑。

大数据核心生态技术栈

这是大数据工程师的“屠龙刀”,是课程的核心。

(图片来源网络,侵删)

- Hadoop生态系统:

- HDFS (分布式文件系统):理解其架构(NameNode, DataNode)、数据块、副本机制。

- YARN (资源调度器):理解其架构(ResourceManager, NodeManager)、资源分配模型。

- MapReduce (分布式计算模型):理解其分而治之的思想、Map和Reduce阶段。

- Hive (数据仓库):学习HiveQL(类SQL),将结构化数据映射到HDFS,进行离线数据分析。

- HBase (NoSQL数据库):学习面向列的存储,适用于海量实时读写场景。

- Flume/Kafka (数据采集):学习如何从各种数据源(日志、数据库、消息队列)实时/离线采集数据。

- Spark生态系统:

- Spark Core:理解RDD(弹性分布式数据集)的原理、编程模型。

- Spark SQL:使用DataFrame/Dataset API进行结构化数据处理,性能远超Hive。

- Spark Streaming/Structured Streaming:学习实时数据处理和流式计算。

- Spark MLlib:Spark内置的机器学习库,用于模型训练和预测。

- 实时计算与消息队列:

- Kafka:深入学习其核心概念(Producer, Consumer, Broker, Topic, Partition),作为数据管道的核心枢纽。

- Flink:作为新一代流处理引擎,学习其事件时间、状态管理、Exactly-Once语义等高级特性。

数据仓库与数据平台

这是将技术落地,构建企业级数据资产的关键。

- 数据仓库理论:

维度建模(星型模型、雪花模型)、ETL/ELT流程、数据分层(ODS, DWD, DWS, ADS)。

- 数据仓库工具:

- Apache Doris / ClickHouse:学习现代MPP分析型数据库,用于快速即席查询和报表。

- Apache Kylin / Hologres:学习预计算引擎,加速OLAP查询。

- 数据治理:

数据质量、数据血缘、元数据管理、数据安全与权限控制。

数据分析与机器学习

这是数据分析师和数据挖掘工程师的核心技能。

- 数据可视化:

- 工具:

Tableau,Power BI,ECharts。 - 仪表盘设计、故事性叙述,将分析结果直观呈现。

- 工具:

- 机器学习算法:

- 监督学习(分类、回归)、非监督学习(聚类、降维)、模型评估与调优(交叉验证、网格搜索)。

- 实践:使用

Scikit-learn库实现常见算法,解决实际业务问题(如用户流失预测、商品推荐)。

- 深度学习入门:

- 神经网络基础、常用框架(

TensorFlow/PyTorch简介)、CNN(图像)、RNN/LSTM(序列)。

- 神经网络基础、常用框架(

项目实战与面试辅导

理论必须结合实践,这是检验学习成果的唯一标准。

- 项目实战:

- 电商用户行为分析平台:从日志数据采集、清洗,到构建用户画像、商品推荐、销售分析报表。

- 实时交通流量监控大屏:通过Kafka采集模拟数据,用Flink进行实时计算,用ECharts/Superset展示实时大屏。

- 电影推荐系统:基于用户评分数据,使用协同过滤算法构建推荐模型。

- 面试辅导:

- 简历优化:如何突出项目经验和技能亮点。

- 面试题库:整理高频面试题(SQL题、算法题、场景题、八股文)。

- 模拟面试:模拟真实面试场景,进行压力面试和沟通演练。

不同方向的学习路径建议

路径1:大数据开发工程师(最主流)

- 打基础:Linux -> Python -> SQL -> Java (可选,但有助于理解底层)。

- 学Hadoop:HDFS -> YARN -> MapReduce -> Hive -> HBase -> Flume/Kafka。

- 学Spark:Spark Core -> Spark SQL -> Spark Streaming -> Spark MLlib。

- 学实时:深入Kafka -> 学习Flink。

- 学平台:了解数据仓库理论、数据分层、ETL工具。

- 做项目:搭建一个完整的大数据处理平台,涵盖离线和实时数据链路。

- 面试:重点准备技术原理、项目细节、调优经验。

路径2:大数据分析师/数据挖掘工程师

- 打基础:SQL(必须精通) -> Python(Pandas, NumPy, Matplotlib, Scikit-learn) -> 统计学。

- 学分析工具:Excel(高级功能) -> Tableau/Power BI。

- 学大数据查询:学习Hive SQL/Spark SQL,掌握在亿级数据上的查询能力。

- 学机器学习:理解常见算法原理,用Python实现,并评估效果。

- 做项目:选择有明确业务目标的分析项目,如用户画像、流失预警、销售预测等。

- 面试:重点准备SQL题、业务分析思路、算法理解、项目成果展示。

路径3:数据平台运维工程师

- 打基础:Linux(精通) -> Shell脚本 -> 网络知识 -> 计算机组成原理。

- 学Hadoop生态:深入理解HDFS、YARN的架构和故障排查。

- 学容器化:Docker -> Kubernetes (K8s),这是现代大数据运维的趋势。

- 学监控与调优:Prometheus + Grafana 监控体系,学习JVM调优、SQL调优。

- 做项目:搭建高可用的Hadoop/Spark集群,并对其进行压测和调优。

- 面试:重点准备系统原理、故障排查经验、性能调优手段、自动化运维能力。

如何选择合适的培训课程?

面对市场上琳琅满目的课程,可以从以下几个方面进行考量:

-

明确自身目标和基础:

- 零基础转行:选择从基础讲起,体系完整,项目驱动的课程。

- 有开发经验:可以选择进阶课程,重点学习大数据技术栈。

- 目标岗位:根据想成为“开发”、“分析”还是“运维”来选择侧重不同的课程。

-

考察课程大纲:

- 是否前沿:是否包含Spark、Flink、Kubernetes等当前企业主流技术?

- 是否全面:基础、核心、项目、面试是否覆盖?有没有明显的短板?

- 是否深入:是只教“怎么用”,还是讲解“为什么这么设计”的底层原理?

-

评估师资力量:

- 讲师背景:讲师是否有一线大厂的真实大数据项目经验?这是课程质量的保证。

- 教学经验:讲师是否善于把复杂问题讲清楚,能否耐心解答学员问题?

-

审视项目实战:

- 项目真实性:项目是模拟真实业务场景,还是随便编造的玩具项目?

- 项目规模:项目的数据量级是否达到TB级别?能否体现技术挑战?

- 项目成果:项目完成后,能否形成一份有分量的作品集,用于求职?

-

考察服务体系:

- 答疑机制:是否有及时的答疑渠道(如社群、专属助教)?

- 就业服务:是否提供简历修改、模拟面试、内推机会等?

- 课程更新是否能跟上技术发展,定期更新?

-

对比口碑与评价:

- 学员评价:多渠道查看往期学员的真实评价,特别是就业情况和课程体验。

- 试听体验:大部分正规机构都提供免费试听,亲身体验讲师风格和课程质量是关键。

希望这份详细的指南能帮助您在互联网大数据学习的道路上找到清晰的方向!祝您学习顺利,成功转型!