Kappa分析培训:从理论到实践

第一部分:为什么需要Kappa分析?—— 问题引入

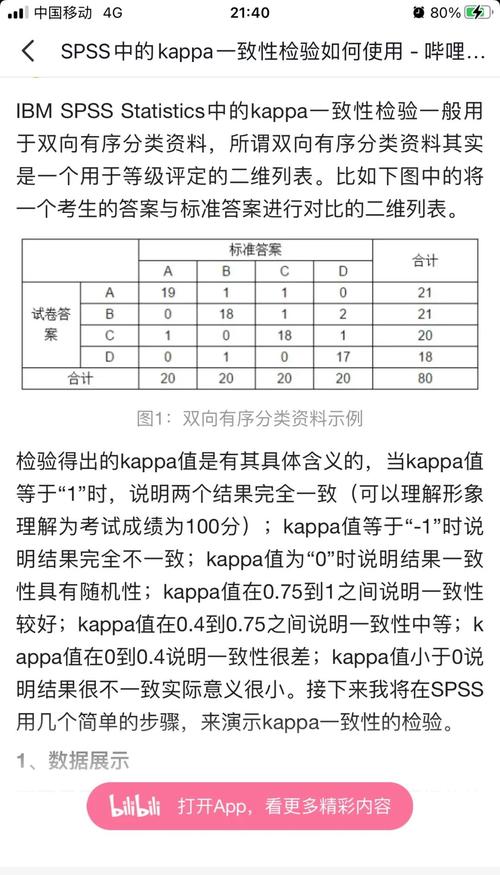

在医学诊断、质量控制、市场调研等领域,我们经常需要评估两个或多个评估者(如医生、检验员、评审员)之间,或者一种新方法与金标准之间的一致性。

最直观的方法是计算“一致性百分比”(Agreement Percentage)。

举例: 两位医生(医生A和医生B)对100张X光片进行诊断,结果分为“阳性”和“阴性”,诊断结果如下:

| 医生B:阳性 | 医生B:阴性 | 总计 | |

|---|---|---|---|

| 医生A:阳性 | 60 | 10 | 70 |

| 医生A:阴性 | 15 | 15 | 30 |

| 总计 | 75 | 25 | 100 |

*一致性百分比 = (一致的对数 / 总数) 100%* = (60 + 15) / 100 100% = 75%

看起来一致性还不错,对吗?这里有一个陷阱!

75%的一致性中,可能包含了“偶然一致性”(Chance Agreement),也就是说,即使两位医生完全不相关,仅仅凭运气,也可能达到一定的一致率,如果疾病本身很常见(阳性率高),两位医生都倾向于诊断为“阳性”,这样即使他们互不相干,一致性也会很高。

Kappa分析(Kappa Analysis)正是为了解决这个问题而生的,它衡量的是“非偶然的一致性”,即校正了机遇一致后,评估者真实达成的一致程度。

第二部分:Kappa分析的核心概念

什么是Kappa系数 (Kappa Statistic, κ)?

Kappa系数是一个统计量,取值范围在 -1 到 +1 之间,它代表了两个评估者之间实际观察到的一致性(Observed Agreement, $P_o$)与期望偶然一致性(Expected Chance Agreement, $P_e$)之差,再除以1减去期望偶然一致性。

核心公式: $$ \kappa = \frac{P_o - P_e}{1 - P_e} $$

- $P_o$ (Observed Agreement): 观察到的一致性,就是我们上面计算的75%。

- $P_e$ (Expected Chance Agreement): 期望的偶然一致性,这是通过假设两个评估者完全独立(随机判断)来计算的。

如何计算 $P_e$ (期望偶然一致性)?

$P_e$ 的计算基于一个假设:两位医生的判断是相互独立的,我们可以用“边际概率”的乘积来估计偶然一致的概率。

回到我们的例子:

- 医生A判断为“阳性”的概率 = 70 / 100 = 0.7

- 医生B判断为“阳性”的概率 = 75 / 100 = 0.75

- 医生A判断为“阴性”的概率 = 30 / 100 = 0.3

- 医生B判断为“阴性”的概率 = 25 / 100 = 0.25

偶然一致性 $P_e$ 是: (医生A阳性且医生B阳性的偶然概率) + (医生A阴性且医生B阴性的偶然概率) = (P(A阳性) P(B阳性)) + (P(A阴性) P(B阴性)) = (0.7 0.75) + (0.3 0.25) = 0.525 + 0.075 = 60 (或 60%)

解读: 即使两位医生完全不相关,凭运气也能达到60%的一致性。

计算Kappa系数 (κ)

现在我们把 $P_o$ 和 $P_e$ 代入核心公式: $$ \kappa = \frac{0.75 - 0.60}{1 - 0.60} = \frac{0.15}{0.40} = 0.375 $$

这个结果(0.375)远比我们最初看到的75%更有意义,因为它告诉我们,在排除了偶然因素的影响后,两位医生的真实一致性为0.375。

第三部分:Kappa系数的结果如何解读?

Kappa系数的值越高,说明一致性越好,学术界普遍采用以下标准(Landis & Koch, 1977),但请注意,这只是一个通用参考,具体领域可能有更严格的标准。

| Kappa (κ) 值 | 一致性强度 | 描述 |

|---|---|---|

| < 0 | 无一致性 | 比偶然预期的还要差 |

| 00 - 0.20 | 轻微一致 | |

| 21 - 0.40 | 尚可一致 | |

| 41 - 0.60 | 中度一致 | |

| 61 - 0.80 | 高度一致 | |

| 81 - 1.00 | 极高一致 |

回到我们的例子: 计算出的 κ = 0.375,根据上表,应评价为“尚可一致”,这说明两位医生的诊断能力有一定相关性,但距离“高度一致”还有差距,需要进一步分析差异点在何处。

第四部分:Kappa分析的详细步骤(以2x2表为例)

目标: 评估评估者A和评估者B之间的一致性。

步骤1:整理数据 制作一个如下的列联表(Contingency Table),记录所有配对结果。

| 评估者B:类别1 | 评估者B:类别2 | 评估者B总计 | |

|---|---|---|---|

| 评估者A:类别1 | a | b | R₁ |

| 评估者A:类别2 | c | d | R₂ |

| 评估者B总计 | C₁ | C₂ | N |

步骤2:计算观察一致性 ($P_o$) $$ P_o = \frac{a + d}{N} $$

步骤3:计算期望偶然一致性 ($P_e$) $$ P_e = \frac{(R_1 \times C_1) + (R_2 \times C_2)}{N^2} $$

步骤4:计算Kappa系数 (κ) $$ \kappa = \frac{P_o - P_e}{1 - P_e} $$

步骤5:进行假设检验(可选但推荐) 我们通常想知道计算出的Kappa系数是否显著不为0(即一致性是否显著优于偶然),这需要用到Z检验。

- 原假设 (H₀): κ = 0 (评估者间无真实一致性,观察到的全靠运气)

- 备择假设 (H₁): κ ≠ 0 (评估者间存在真实一致性)

统计软件(如SPSS, R, Python)会自动计算P值。P < 0.05,我们就可以拒绝原假设,认为Kappa系数具有统计学意义,即评估者间的一致性是真实存在的,而非偶然。

第五部分:Kappa分析的进阶

加权Kappa (Weighted Kappa, κw)

- 适用场景: 当评估结果是有序分类变量(如:轻微、中等、严重)时。

- 问题: 在有序分类中,“轻微”和“中等”的差异小于“轻微”和“严重”的差异,标准Kappa将所有不一致都视为同等代价,这会损失信息。

- 解决方案: 引入“权重矩阵”,对不同等级的不一致性给予不同的“惩罚”。

- 完全一致(如A评“轻微”,B评“轻微”):权重=1

- 相邻不一致(如A评“轻微”,B评“中等”):权重=0.8

- 相隔一级不一致(如A评“轻微”,B评“严重”):权重=0.4

- 完全不一致(如A评“轻微”,B评“轻微”):权重=0

- 加权Kappa通过这些权重来计算一个更精确的、考虑了差异程度的“一致性”。

多个评估者或多个类别

- Fleiss' Kappa: 用于评估三个或以上评估者之间的一致性,而评估结果可以是两个或多个类别,其原理与Cohen's Kappa类似,但扩展了计算方法,适用于更复杂的场景。

第六部分:实际应用与案例分析

案例: 一位资深病理师(金标准)和一位年轻病理师对100名患者的肿瘤切片进行诊断(良性、恶性),结果如下:

| 年轻病理师:恶性 | 年轻病理师:良性 | 总计 | |

|---|---|---|---|

| 资深病理师:恶性 | 45 | 5 | 50 |

| 资深病理师:良性 | 10 | 40 | 50 |

| 总计 | 55 | 45 | 100 |

分析过程:

-

计算 $P_o$: $P_o = (45 + 40) / 100 = 85/100 = 0.85$

-

计算 $P_e$: $P_e = ( (50/100) (55/100) ) + ( (50/100) (45/100) )$ $P_e = (0.5 0.55) + (0.5 0.45) = 0.275 + 0.225 = 0.50$

-

计算 κ: $\kappa = (0.85 - 0.50) / (1 - 0.50) = 0.35 / 0.50 = 0.70$

-

解读结果:

- Kappa值为0.70,属于“高度一致”。

- 这表明,在排除了偶然因素后,年轻病理师与资深病理师的诊断一致性很高。

- 进一步分析可以发现,主要的误诊在于假阳性(5例良性被误诊为恶性)和假阴性(10例恶性被误诊为良性),年轻病理师可能对恶性诊断更谨慎,导致假阳性略高。

第七部分:注意事项与局限性

- 样本量: 样本量过小会导致Kappa值不稳定,结果不可靠,一般建议总样本量N > 40。

- 边际分布: 如果两个评估者对各类别的判断频率差异很大(即边际分布不均衡),Kappa值可能会被低估,即使观察一致性很高,Kappa也可能偏低。

- 类别数: 类别越少,偶然一致性 $P_e$ 越高,Kappa值越难达到高水平。

- Kappa≠准确性: Kappa衡量的是一致性,而不是准确性,两个评估者可以高度一致,但可能都系统地错了(都使用了一个有缺陷的检测方法)。

- 不是万能的: 对于有序数据,优先考虑加权Kappa,对于多个评估者,使用Fleiss' Kappa。

第八部分:如何使用软件进行Kappa分析?

-

SPSS:

分析->标度->可靠性分析。- 将你的两个评估者的变量选入“项目”框。

- 在“统计”对话框中,勾选“Kappa”。

- 点击“继续”和“确定”,即可输出Kappa值及其P值。

-

R: 使用

irr包。# 安装和加载包 install.packages("irr") library(irr) # 创建数据框 data <- data.frame( rater1 = c(rep(1, 45), rep(0, 5), rep(1, 10), rep(0, 40)), # 1=恶性, 0=良性 rater2 = c(rep(1, 55), rep(0, 45)) ) # 计算Kappa kappa2(data, weight = "unweighted") # 标准Kappa kappa2(data, weight = "equal") # 加权Kappa (线性权重) kappa2(data, weight = "squared") # 加权Kappa (二次权重) -

Python: 使用

statsmodels库。import pandas as pd from statsmodels.stats.inter_rater import cohens_kappa # 创建数据 data = pd.DataFrame({ 'rater1': [1]*45 + [0]*5 + [1]*10 + [0]*40, # 1=恶性, 0=良性 'rater2': [1]*55 + [0]*45 }) # 计算Kappa kappa = cohens_kappa(table=data, weights=None) # 标准Kappa print(kappa)

总结与Q&A

Kappa分析是评估分类变量一致性的强大工具,它通过校正偶然因素,为我们提供了一个更真实、更可靠的一致性度量,理解其核心思想($P_o - P_e$)和解读标准,是正确应用它的关键。

Q&A环节:

-

Q: 一致性百分比和Kappa值,我应该看哪个?

- A: 两者结合看,一致性百分比告诉你总的符合情况,Kappa值告诉你这个符合情况中有多少是“真”的,一个高的一致性百分比可能对应一个很低的Kappa值,这通常是一个危险信号,说明评估者可能只是在“随大流”。

-

Q: Kappa值为负数是什么意思?

- A: 这意味着观察到的一致性比预期的偶然一致性还要差,两位评估者似乎在刻意“唱反调”,或者评估标准非常模糊导致他们完全随机判断且结果相反,这种情况在现实中比较少见。

-

Q: 我的Kappa值是0.4,P值是0.06,应该怎么判断?

- A: 这是一个典型的“边缘情况”,Kappa值0.4提示“尚可一致”,但P=0.06 > 0.05,意味着从统计学上,我们尚不能认为这种一致性显著优于偶然,你需要谨慎下结论,可能需要增加样本量或检查评估过程是否存在问题。

希望这份详细的培训材料能帮助您全面掌握Kappa分析!